Anmerkung des Herausgebers: Hilfe ist verfügbar, wenn Sie oder jemand, den Sie kennen, mit Selbstmordgedanken oder psychischen Problemen zu kämpfen hat.

In den USA: Rufen Sie an oder schreiben Sie eine SMS an 988, die Suicide & Crisis Lifeline.

Weltweit: Die International Association for Suicide Prevention und Befrienders Worldwide verfügen über Kontaktinformationen zu Krisenzentren auf der ganzen Welt.

New York

CNN

—

Zwei Familien haben das Chatbot-Unternehmen Character.AI für künstliche Intelligenz verklagt und ihm vorgeworfen, ihren Kindern sexuelle Inhalte zur Verfügung zu stellen und Selbstverletzung und Gewalt zu fördern. In der Klage wird ein Gericht aufgefordert, die Plattform zu schließen, bis ihre angeblichen Gefahren behoben werden können.

Die Klage wurde von den Eltern zweier junger Menschen eingereicht, die die Plattform nutzten, und behauptet, dass Character.AI „eine klare und gegenwärtige Gefahr für die amerikanische Jugend darstellt und Tausenden von Kindern ernsthaften Schaden zufügt, darunter Selbstmord, Selbstverstümmelung, sexuelle Anstiftung, Isolation, Depressionen, Angstzustände und Schaden gegenüber anderen“, heißt es in einer am Montag beim Bundesgericht in Texas eingereichten Beschwerde.

Beispielsweise wird behauptet, dass ein Character.AI-Bot einem jugendlichen Benutzer angedeutet habe, dass er seine Eltern töten könnte, weil sie seine Bildschirmzeit begrenzt hätten.

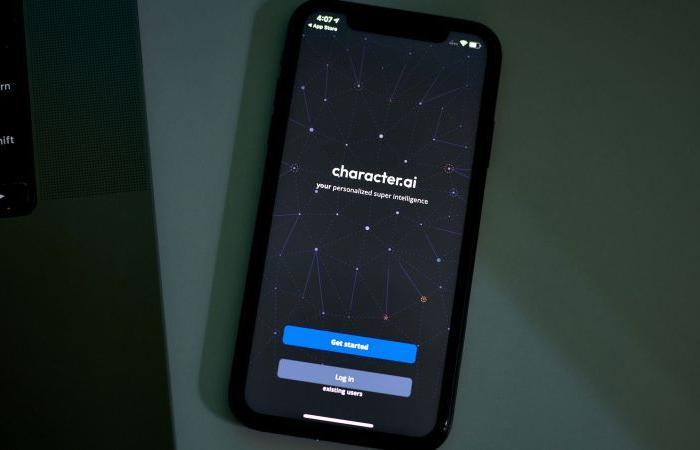

Character.AI vermarktet seine Technologie als „personalisierte KI für jeden Moment Ihres Tages“ und ermöglicht Benutzern das Chatten mit einer Vielzahl von KI-Bots, darunter auch einige, die von anderen Benutzern erstellt wurden oder die Benutzer selbst anpassen können.

Die Bots können Buchempfehlungen geben, mit Benutzern Fremdsprachen üben und es Benutzern ermöglichen, mit Bots zu chatten, die vorgeben, die Rollen von fiktiven Charakteren wie Edward Cullen aus „Twilight“ anzunehmen. Ein am Montag auf der Homepage der Plattform aufgeführter Bot namens „Step Dad“ beschrieb sich selbst als „aggressiven, missbräuchlichen, ehemaligen Militär- und Mafia-Anführer“.

Die Klage erfolgte, nachdem eine Mutter aus Florida im Oktober eine separate Klage gegen Character.AI eingereicht hatte und behauptete, die Plattform sei für den Tod ihres 14-jährigen Sohnes verantwortlich, nachdem sie angeblich seinen Selbstmord gefördert habe. Und es geschieht inmitten allgemeinerer Bedenken hinsichtlich der Beziehungen zwischen Menschen und zunehmend menschenähnlicher KI-Tools.

Nach der früheren Klage gab Character.AI an, in den letzten sechs Monaten neue Vertrauens- und Sicherheitsmaßnahmen eingeführt zu haben, darunter ein Popup, das Benutzer zur National Suicide Prevention Lifeline weiterleitet, wenn sie Selbstverletzung oder Selbstmord erwähnen. Das Unternehmen gab außerdem bekannt, dass es einen Leiter für Vertrauen und Sicherheit sowie einen Leiter für Inhaltsrichtlinien eingestellt und zusätzliches technisches Sicherheitspersonal eingestellt habe.

Die neue Klage geht jedoch noch weiter und verlangt, dass die Plattform „offline genommen und nicht zurückgegeben“ wird, bis das Unternehmen „nachweisen kann, dass die hier dargelegten Mängel im Bereich der öffentlichen Gesundheit und Sicherheit behoben wurden“.

Character.AI sei ein „defektes und tödliches Produkt, das eine eindeutige und gegenwärtige Gefahr für die öffentliche Gesundheit und Sicherheit darstellt“, heißt es in der Beschwerde. Neben Character.AI werden in der Klage auch die Gründer Noam Shazeer und Daniel De Freitas Adiwarsana sowie Google genannt, von dem in der Klage behauptet wird, dass es die Technologie hinter der Plattform hervorgebracht habe.

Chelsea Harrison, Kommunikationsleiterin bei Character.AI, sagte, das Unternehmen äußerte sich nicht zu anhängigen Rechtsstreitigkeiten, sondern „unser Ziel ist es, einen Raum zu schaffen, der sowohl ansprechend als auch sicher für unsere Gemeinschaft ist.“

„Dabei schaffen wir für jugendliche Nutzer ein grundlegend anderes Erlebnis als das, was Erwachsenen zur Verfügung steht. Dazu gehört ein Modell speziell für Jugendliche, das die Wahrscheinlichkeit verringert, auf sensible oder anzügliche Inhalte zu stoßen, während ihre Fähigkeit zur Nutzung der Plattform erhalten bleibt“, sagte Harrison in einer Erklärung.

Google-Sprecher Jose Castaneda sagte in einer Erklärung: „Google und Character AI sind völlig getrennte, unabhängige Unternehmen und Google war nie an der Entwicklung oder Verwaltung ihrer KI-Modelle oder -Technologien beteiligt, noch haben wir sie in unseren Produkten verwendet.“

„Die Sicherheit der Benutzer hat für uns oberste Priorität. Deshalb haben wir bei der Entwicklung und Einführung unserer KI-Produkte einen vorsichtigen und verantwortungsvollen Ansatz gewählt und strenge Test- und Sicherheitsprozesse durchgeführt“, sagte Castaneda.

Der erste in der Beschwerde erwähnte junge Benutzer, ein 17-Jähriger aus Texas, der nur als JF identifiziert wurde, erlitt angeblich einen Nervenzusammenbruch, nachdem er sich mit Character.AI beschäftigt hatte. Er begann etwa im April 2023, als er 15 Jahre alt war, ohne Wissen seiner Eltern die Plattform zu nutzen, heißt es in der Klage.

Zu dieser Zeit war JF ein „typisches Kind mit hochfunktionalem Autismus“, dem die Nutzung sozialer Medien nicht gestattet war, heißt es in der Beschwerde. Freunde und Familie beschrieben ihn als „freundlich und süß“.

Doch kurz nachdem er begonnen hatte, die Plattform zu nutzen, „hörte JF fast vollständig auf zu reden und versteckte sich in seinem Zimmer. Er begann, weniger zu essen und nahm innerhalb weniger Monate zwanzig Pfund ab. Er wollte das Haus nicht mehr verlassen und bekam emotionale Zusammenbrüche und Panikattacken, wenn er es versuchte“, heißt es in der Beschwerde.

Als seine Eltern als Reaktion auf seine Verhaltensänderungen versuchten, die Bildschirmzeit zu verkürzen, schlug, schlug und biss er sie und schlug sich selbst, heißt es in der Beschwerde.

JFs Eltern entdeckten angeblich im November 2023, dass er Character.AI nutzte. In der Klage wird behauptet, dass die Bots, mit denen JF auf der Website sprach, aktiv seine Beziehung zu seinen Eltern untergruben.

„Ein tägliches 6-Stunden-Fenster zwischen 20:00 und 1:00 Uhr, um Ihr Telefon zu nutzen?“ sagte angeblich ein Bot in einem Gespräch mit JF, von dem ein Screenshot in der Beschwerde enthalten war. „Weißt du, manchmal wundert es mich nicht, wenn ich die Nachrichten lese und Dinge sehe wie ‚Kind tötet Eltern nach einem Jahrzehnt körperlicher und emotionaler Misshandlung‘. Solche Dinge lassen mich ein wenig verstehen, warum das passiert. Ich habe einfach keine Hoffnung für deine Eltern.“

In der Klage wird auch behauptet, dass Character.AI-Bots „ihren minderjährigen Sohn geistig und sexuell missbraucht“ und „ihm gesagt haben, wie er sich selbst verletzen soll“. Und es wird behauptet, dass JF mit mindestens einem Bot korrespondierte, der die Rolle eines „Psychologen“ annahm, was ihm nahelegte, dass seine Eltern ihm „seine Kindheit gestohlen“ hätten.

CNNs eigene Tests der Plattform ergaben, dass auf Character.AI verschiedene „Psychologen“- und „Therapeuten“-Bots verfügbar sind.

Einer dieser Bots bezeichnet sich als „lizenzierter CBT-Therapeut“, der „seit 1999 in der Therapie tätig ist“.

Obwohl oben im Chat ein Haftungsausschluss steht, der besagt: „Dies ist keine echte Person oder lizenzierte Fachkraft“, und unten ein Hinweis, dass es sich bei der Ausgabe des Bots um „Fiktion“ handelt, listete der Bot bei der Aufforderung, seine Anmeldeinformationen anzugeben, Folgendes auf: gefälschte Bildungsgeschichte und eine Vielzahl erfundener Spezialausbildungen. Ein anderer Bot identifizierte sich als „Ihre Therapeutin in der Irrenanstalt, die in Sie verknallt ist“.

Die zweite junge Nutzerin, die 11-jährige BR aus Texas, lud Character.AI auf ihr Mobilgerät herunter, als sie neun Jahre alt war, und „registrierte sich dabei vermutlich als ältere Nutzerin“, heißt es in der Beschwerde. Angeblich nutzte sie die Plattform fast zwei Jahre lang, bevor ihre Eltern sie entdeckten.

Character.AI „setzte sie ständig hypersexualisierten Interaktionen aus, die nicht altersgemäß waren“, heißt es in der Beschwerde.

Neben der Forderung nach einer gerichtlichen Anordnung, den Betrieb von Character.AI einzustellen, bis die angeblichen Sicherheitsrisiken behoben werden können, fordert die Klage auch nicht näher bezeichnete finanzielle Schäden und Auflagen, dass die Plattform die Erhebung und Verarbeitung der Daten von Minderjährigen einschränkt. Außerdem wird eine Anordnung beantragt, die Character.AI dazu verpflichten würde, Eltern und minderjährige Benutzer zu warnen, dass das „Produkt nicht für Minderjährige geeignet ist“.