Mit dem Aufkommen großer Sprachmodelle wie ChatGPT beginnen immer mehr Unternehmen zu behaupten, dass ihre Modelle in der Lage seien, „Schlussfolgerungen zu ziehen“, d. h. aus ihrem Wissen zu extrapolieren, um gültige, logisch gültige Schlussfolgerungen für ein völlig neues Problem zu ziehen.

Aber eine neue Studie von Ars Tecnica zeigt deutlich, dass es noch zu früh ist, über die Realität zu sprechen.“ Argumentation „Und dass selbst die besten aktuellen Modelle dazu neigen, spektakulär zusammenzubrechen, wenn sie mit banalen Fallstricken konfrontiert werden.

Ein prozessualer Bezugspunkt, um die Bewertung aufzupeppen

Um dies zu beweisen, haben sich die Autoren dieser Studie, sechs Apple-Ingenieure, berufen GSM8Kein Datensatz bestehend aus 8000 Mathematikaufgaben der Grundschule. Dies ist ein Benchmark, der häufig von Entwicklern verwendet wird, um die sogenannten Fähigkeiten von „ Argumentation » ihrer Modelle. Beispielsweise erzielte die erste Version von GPT-4 bei diesem Benchmark eine Punktzahl von 92 %, und OpenAI präsentierte sie als „ Beweise für überlegenes mathematisches Denken und Problemlösungsfähigkeiten ».

Das Problem besteht darin, dass diese Art von Benchmark in der Praxis wenig relevant ist. In vielen Fällen wurden die Fragen und Antworten direkt in die Trainingsdaten integriert, sodass Modelle sofort die richtige Antwort liefern können, ohne dass eine tatsächliche Begründung erforderlich ist.

Apple-Forscher beschlossen daraufhin, eine strengere Variante von GSMK8 namens zu entwickeln GSM-symbolisch. Der große Unterschied besteht darin, dass Letzteres ein ist prozeduraler, dynamischer Bezugspunkt, der eine gewisse Variabilität beinhaltet. Anstatt die Deklarationen unverändert direkt in die Modelle einzuspeisen, hat das Team ein einfaches Programm erstellt, mit dem Sie bestimmte Elemente durch andere Werte ersetzen können. Beispielsweise könnte die Frage, wie lange ein Konditor braucht, um 30 Kuchen zu backen, zu einer Frage über einen Mechaniker werden, der versucht, 15 Autos zu reparieren.

Wichtig ist, dass die Forscher sehr sorgfältig darauf achteten, dass diese Änderungen keinen Einfluss auf die Art der erforderlichen Argumentation oder die Schwierigkeit hatten. Genau das gleiche Problem nach der Änderung, nur anders maskiert. Um das obige Beispiel zu nehmen, muss man immer die Anzahl der Produkte mit einer Zeiteinheit multiplizieren; Die Tatsache, dass in der Aussage von der Zubereitung eines Desserts oder der Reparatur eines Fahrzeugs die Rede ist, ändert nichts an der Herangehensweise an das Problem. Wenn die LLMs wirklich in der Lage wären, zu argumentieren, hätten sie theoretisch mehr oder weniger identische Ergebnisse beim GSKM8 und beim GSM-Symbolic erzielen müssen.

Triviale, aber verheerende logische Fallen

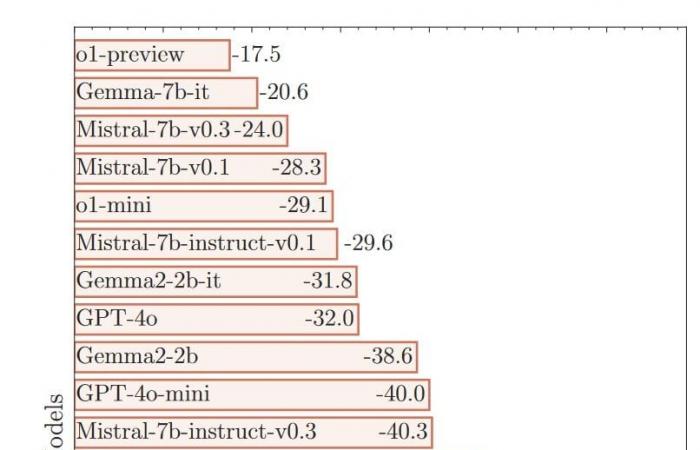

Aber wie Sie sich wahrscheinlich vorstellen können, geschah genau das Gegenteil! Die Forscher fanden heraus, dass ausnahmslos alle getesteten Modelle bei GSM-Symbolic deutlich schlechter abschnitten. Einige waren von diesen kleinen Änderungen völlig verwirrt. Bei Mistral-7b-it-v0.1 beispielsweise sank die Punktzahl auf GSM-Symbolic um 9,2 %.

Und das sind nicht die einzigen Daten, die die tatsächlichen Lücken verdeutlichen. Die Autoren stellten außerdem eine sehr große Variabilität von Test zu Test fest. Über 50 aufeinanderfolgende Iterationen von GSM-Symbolic, jedes Mal mit unterschiedlichen Werten, aber immer dem gleichen Grundproblem, Die Ergebnisse können um ca. 15 % variieren. – in diesem Zusammenhang eine ziemlich große Zahl.

Andererseits haben einige Modelle wie GPT-4o relativ gute Leistungen erbracht. Das OpenAI-Produkt weist von einem Benchmark zum anderen einen Rückgang von 0,3 % auf, was auf den ersten Blick nahezu vernachlässigbar erscheint. Können wir also davon ausgehen, dass er tatsächlich zu logischem Denken fähig ist?

Um dies zu testen, starteten die Forscher ihr Experiment neu, indem sie neue Fallen einführten. Genauer gesagt fügten sie hinzu: „ scheinbar relevante, aber eigentlich irrelevante Aussagen » zu den Erklärungen. Beispielsweise gaben die Forscher bei einer Frage nach der Anzahl der über mehrere Tage geernteten Kiwis an, dass einige Früchte etwas kleiner seien als andere. Da die Antwort überhaupt nicht von der Größe oder dem Gewicht der Kiwis abhängt, würde ein Erwachsener sofort verstehen, dass diese Präzision nicht berücksichtigt werden muss.

Würde ein Kind darauf hereinfallen? Vielleicht, und es wäre interessant gewesen, eine vergleichende Unterrichtsstudie durchzuführen, um dies zu beurteilen. Sicher ist jedoch, dass die LLMs alle getäuscht wurden. Diese Ablenkungen, so grundlegend sie auch sein mochten, führten dazu, dass sie völlig die Kontrolle verlorenwas zu dem führt, was Forscher als „ katastrophale Leistungseinbußen „. GPT-4o, das im vorherigen Test gut abgeschnitten hatte, musste einen Rückgang der Punktzahl um 32 % hinnehmen. Andere sind völlig zusammengebrochen, wie Phi-3-mini-128k-instruct und seine besorgniserregende Genauigkeit von -65,7 % …

Keine wirkliche Argumentation unter LLMs

Für die Autoren der Studie deuten diese Daten auf ein „ Kritischer Fehler „. Dies deutet darauf hin, dass es echte gibt“ Grundlegende Probleme im Argumentationsprozess » was nicht einfach dadurch gelöst werden kann, dass die Gewichtungen und Verzerrungen, die sich auf die Funktionsweise der Modelle auswirken, verfeinert werden. Es wäre notwendig, es besser zu machen von Grund auf mit einer völlig anderen Architektur beginnen.

Basierend auf diesen sehr aussagekräftigen Ergebnissen argumentieren die Forscher: „ Aktuelle LLMs sind nicht in der Lage, wirklich logisch zu argumentieren „. In Wirklichkeit versuchen sie, diese Lücke zu vertuschen.“ Versuchen, Argumentationsschritte im Zusammenhang mit anderen Problemen in ihren Trainingsdaten zu reproduzieren „. Mit anderen Worten, Sie verhalten sich ein wenig wie ein junger Student, der sein Notizbuch auswendig gelernt hat ; Solange sie auf gewohntem Terrain bleiben, bekommen sie zwar eine hervorragende Note, aber die Illusion bricht sofort zusammen, sobald sie ihre Komfortzone verlassen, denn letztendlich haben sie keine Ich habe nichts von der zugrunde liegenden Logik verstanden.

Es ist eine Schlussfolgerung, die wahrscheinlich niemanden überraschen wird. Schließlich handelt es sich bei diesen LLMs im Wesentlichen um Vorhersagesysteme, die sehr gut darin sind, Muster zu erkennen, die uns entgehen. Am Ende bleiben sie Ratemaschinen. Natürlich machen sie das oft sehr effektiv, aber es bleibt ein Problem Ansatz, der sich grundlegend von echten konstruierten Überlegungen unterscheidet.

Es ist nicht das erste Mal, dass Fachleute die Idee ablehnen, dass LLMs mit Vernunft ausgestattet sind, aber diese Studie ist ein guter Beweis dafür die immense Kluft, die geschäftliche Bedürfnisse und konkrete Realität trennt. Keine Beleidigung für Sam Altman, CEO von OpenAI, die von ihm oft erwähnte künstliche allgemeine Intelligenz (AGI) ist noch lange nicht in der Reichweite aktueller Modelle.

Auf dem Weg zu einem großen Paradigmenwechsel?

Generell können wir die Grenzen aktueller LLMs berechtigterweise in Frage stellen. Experten argumentieren seit langem, dass der aktuelle Ansatz wahrscheinlich an seine Grenzen stößt, was zum Teil auf einen unangemessenen Schulungsprozess zurückzuführen ist. Der Mensch ist ein gutes Beispiel dafür.

Wir wissen sehr gut, dass die Erfassung von Rohinformationen zur Extraktion wiederkehrender Muster, wie es bei LLMs der Fall ist, nicht ausreicht.. Wenn der Lehrplan für Kinder darin bestehen würde, sich einfach das gesamte Wörterbuch und Millionen von Seiten mit Additions- und Multiplikationstabellen zu merken, würden sie wahrscheinlich unter den gleichen logischen Lücken leiden wie KI-Modelle! Wenn sie im Laufe ihres Lebens wahre Intelligenz entwickeln können, liegt das vor allem daran, dass wir sie ihnen vermitteln abstraktere und konzeptionellere Vorstellungenauf die sie sich später verlassen können.

Die Herausforderung besteht darin, einen Weg zu finden, dasselbe mit KI-Modellen zu erreichen. Aber das ist eine große technische Herausforderung, die zweifellos eine … mit sich bringen wird mittel- oder sogar langfristig ein wichtiger Paradigmenwechsel.

Daher ist es angebracht, die Fortschritte der KI-Forscher zu verfolgen, denn diese technologische Revolution steht erst am Anfang. Drücken wir aber gleichzeitig auch die Daumen, dass Unternehmen aufhören, diese irreführenden Begriffe zu verwenden, die bei weniger technisch versierten Internetnutzern zu der Annahme führen können, dass sie es bereits mit bewussten, wirklich intelligenten Wesen zu tun haben.

Den Text der Studie finden Sie hier.

???? Um keine Neuigkeiten im Journal du Geek zu verpassen, abonnieren Sie Google News. Und wenn Sie uns lieben, haben wir jeden Morgen einen Newsletter.