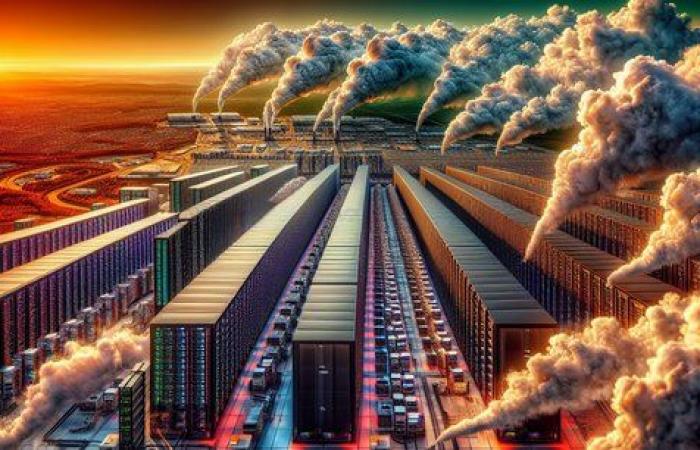

Können wir die Leistungsfähigkeit künstlicher Intelligenz weiter steigern, ohne unseren Planeten zu gefährden? In den letzten Wochen haben sich die Warnzeichen vervielfacht. OpenAI, der Erfinder von ChatGPT, warnte kürzlich das Weiße Haus, dass jedes seiner zukünftigen Rechenzentren wahrscheinlich „ mehr Energie, als eine ganze Stadt mit Strom versorgt.“

Im selben Monat unterzeichneten das Energieunternehmen Constellation Energy und Microsoft eine 20-Jahres-Vereinbarung zur Wiederinbetriebnahme des Kernkraftwerks Three Mile Island in Pennsylvania, dem Ort des schwersten radiologischen Unfalls, den die Vereinigten Staaten je erlebt haben. Google wiederum gab zu, dass es Schwierigkeiten habe, seine CO2-Neutralitätsziele zu erreichen.

„Der Einsatz von KI ist eine Frage von Leben und Tod für ein Unternehmen“ (Emilie Sidiqian, Frankreich-Direktorin von Salesforce)

Der Trend verbreitet sich in den Vereinigten Staaten, wo die meisten großen generativen KI-Modelle entwickelt werden. So sehr, dass ein Bericht von BloombergNEF vor einer Verlangsamung der Fortschritte des Landes bei der Dekarbonisierung warnt. Die Emissionen würden bis 2030 nur um 34 % gegenüber dem Niveau von 2005 sinken, was weit vom Ziel von 50 bis 52 % entfernt wäre. Die Ursache laut diesem Bericht: KIs Energiebulimie.

Ein forcierter Marsch der Demokratisierung

„Alle Webgiganten investieren in die Infrastruktur, priorisieren die Modellleistung und vernachlässigen die Energiekosten.“ fasst Tristan Nitot zusammen, stellvertretender Direktor bei OCTO Technology, Spezialist für nachhaltige Digitalisierung. Vor ein paar Wochen schob Eric Schmidt, ehemaliger Google-Chef und Großinvestor in KI, das Thema während einer Konferenz beiseite. „Wir werden die Ziele auf keinen Fall erreichen, weil wir nicht dazu organisiert sind. Der Energiebedarf der KI wird problematisch sein, aber ich wette lieber darauf, dass die KI die Umweltkrise löst, als sie zu erzwingen, und das Problem auf jeden Fall zu haben. »

Aber ist diese techno-lösungsorientierte Wette angesichts der raschen Demokratisierung der künstlichen Intelligenz und der damit verbundenen steigenden Energiekosten haltbar? Generative KI wird mittlerweile in sehr gängige Produkte integriert. Denken Sie an die neue Version von iOS, ausgestattet mit „Apple Intelligence“, die Ihre Benachrichtigungen und Nachrichten schnell in einem Satz zusammenfasst, oder an Googles AI Overviews, das Internetnutzern in hundert Ländern eine von der KI zusammengestellte Zusammenfassung der Ergebnisse bietet ihre Forschung… Von nun an wirft die Verwendung von ChatGPT und anderen Fragen auf. Nach Angaben der Internationalen Energieagentur (IEA) würde eine Anfrage an den OpenAI-Chatbot fast zehnmal mehr Strom verbrauchen als eine einfache Abfrage bei Google.

Zu dieser Wirkung kommt noch die bekanntere Wirkung des Trainings hinzu. Dies ist die Phase, in der KI-Modelle eine große Datenmenge „lesen“ und dann die Beantwortung von Anfragen üben. Diese Arbeit erfordert mehrere Tage, sogar Wochen der Berechnung und eine riesige Datenmenge. Erschwerend kommt hinzu, dass sich die notwendige Infrastruktur vor allem in Ländern befindet, in denen Energie nach wie vor CO2-intensiv ist, etwa in den USA, Irland, aber auch in Deutschland.

Wie Theremia KI nutzt, um die Wirksamkeit von Medikamenten zu optimieren

Aber wie Tristan Nitot betont, „Es ist nicht nur eine Frage der Elektrizität.“ Auch der Wasserverbrauch ist ein zentrales Thema. Um überhitzte Rechenzentren zu kühlen, nutzt Big Tech Kühltürme, die blaues Gold verbrauchen. So stieg der Wasserverbrauch von Microsoft im Vergleich zu 2021 um ein Drittel, bei Google um 21 %. „Wir müssen auch über den gesamten Lebenszyklus der KI nachdenken, fügt er hinzu. Es beginnt mit der Gewinnung der Metalle und dann mit ihrem Transport zu den Fabriken, die die für ihre Entwicklung notwendigen Prozessoren herstellen, insbesondere in Taiwan.“ Und der Prozessorverbrauch explodiert, angetrieben durch die Erneuerung der Computerhardware, um sie mit KI-Funktionalitäten kompatibel zu machen.

Angesichts dieser tödlichen Beobachtung bleibt die Technologiebranche nicht untätig. Nvidia ist stolz darauf, die Energieeffizienz seiner GPUs ständig zu verbessern. Diese Chips sind für das Training der besten KI unerlässlich. Rechenzentren führen neue Kühltechnologien namens „Direktkühlung“ ein, bei denen eine Flüssigkeit mit Raumtemperatur direkt in die Server eingeleitet wird. Eine Technik, die weniger Wasser und Strom verbraucht.

Die Angst vor dem Rebound-Effekt

„Wir sehen beeindruckende Verbesserungen, aber wir haben noch nie in der Geschichte der Menschheit so viel Kohle verbraucht. Ich verstehe nicht, warum KI dem Jevons-Paradoxon entkommen sollte.“ Allerdings glaubt Gaël Varoquaux, Forscher bei Inria. Dieses Paradoxon, auch „Rebound-Effekt“ genannt, besagt, dass der Gesamtverbrauch dieser Ressource zunimmt, anstatt zu sinken, wenn technologische Verbesserungen die Effizienz steigern, mit der eine Ressource genutzt wird.

Auch softwareseitig sind Fortschritte sichtbar. Der Trend geht dahin, kleine Modelle zu entwickeln, die für bestimmte Anwendungsfälle genauso effektiv sind, aber bis zu zehnmal weniger Rechenleistung benötigen. Diese kleinen KIs haben außerdem den Vorteil, dass sie auf herkömmlicher Computerhardware, etwa einem Smartphone oder einem Computer, laufen können.

Über diese technischen Fortschritte hinaus wird es notwendig sein „Sich selbst disziplinieren“ in den Worten von Gilles Babinet, Präsident des National Digital Council. „Wir müssen aufhören, Modelle ständig zu aktualisieren, da die Energiekosten für deren Training nach wie vor das größte Problem darstellen. Wir müssen eine spezifischere KI bevorzugen und bestimmte dumme oder nicht hilfreiche Anwendungen diskriminieren.“ sagt er.

Künstliche Intelligenz: Die Wut der Künstler

Doch während die digitalen Giganten uns überall generative KI verkaufen wollten, sind diese weniger nützlichen Einsatzmöglichkeiten für einige bereits Teil des täglichen Lebens. Pierre-Yves Oudeyer, Forschungsdirektor bei Inria, der sich besonders für den Einsatz generativer KI bei jungen Menschen interessiert, beobachtet, dass ihnen diese Technologie manchmal als Hilfe dient„universelle Schnittstelle“. Sie fragen ihn nach Informationen wie dem Ergebnis eines Basketballspiels oder der Hauptstadt eines Landes, die eine einfache Google-Anfrage problemlos geliefert hätte. „Es ist, als würde man mit einem Bulldozer eine Fliege zerquetschen“ er fasst zusammen. Für ihn ist die Aufklärung der Benutzer über Umweltthemen von wesentlicher Bedeutung für die Rationalisierung der Nutzung. Werden wir uns nach der Schande des Fliegens für jede ChatGPT-Anfrage schuldig fühlen?